Nieuwe beelden maken en stemmen ‘klonen’: ondermijnt AI nu al de democratie?

Toepassingen op basis van artificiële intelligentie zoals ChatGPT braken in 2023 door in de samenleving. Ook in de politiek. Is dat een zegen of een vloek?

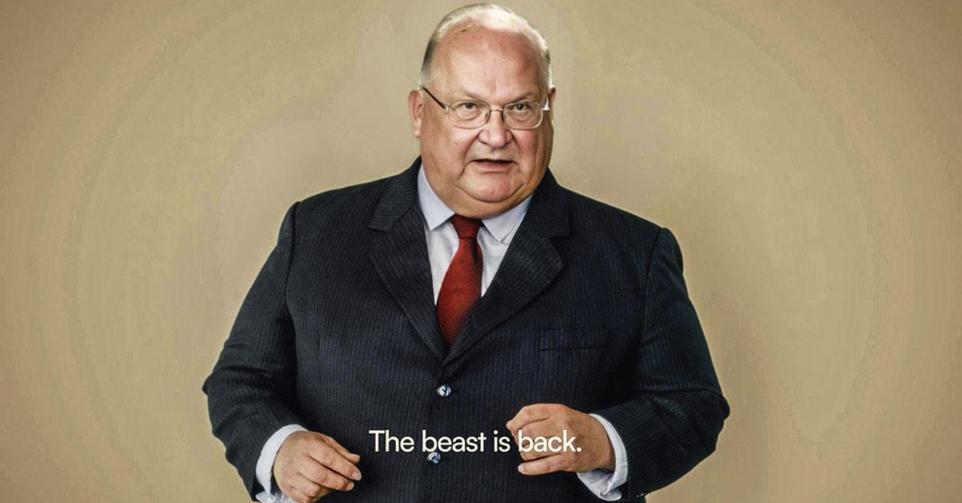

‘The beast is back.’ Op sinterklaasdag, 6 december, verbaasde de CD&V met een filmpje waarin de partij haar in 2014 overleden boegbeeld Jean-Luc Dehaene liet verrijzen om zijn steun uit te spreken voor de campagneslogan ‘Respect werkt’. ‘Deze video is gemaakt met behulp van AI’, stond erbij vermeld. Meer in detail ging het om een acteur, een stemimitator, en een combinatie van AI-technologie en beeldbewerkingssoftware die het gezicht van Dehaene reconstrueerden. Ook aan de stem was gesleuteld met AI-technologie.

De reacties waren verdeeld, al waren de negatieve en zelfs verontwaardigde commentaren in de meerderheid. ‘We doen dit met het grootste respect en hebben vooraf toestemming gevraagd aan de familie. Zij hebben het filmpje ook vooraf bekeken’, verduidelijkte de CD&V. De stunt deed een geanimeerde discussie losbarsten, inclusief oproepen om het gebruik van AI in politieke campagnes te verbieden – of toch zeker met de beeltenis van overledenen.

Ontegensprekelijk is 2023 het jaar waarin AI-toepassingen zoals chatbots (ChatGPT, Google Bard) en beeldgeneratoren (Midjourney, DALL-E) een breed publiek hebben bereikt. Maar hoe zit het met het gebruik van AI-toepassingen in de politiek? Op welke manier heeft AI daar al impact? En wat zijn de gevaren voor de toekomst?

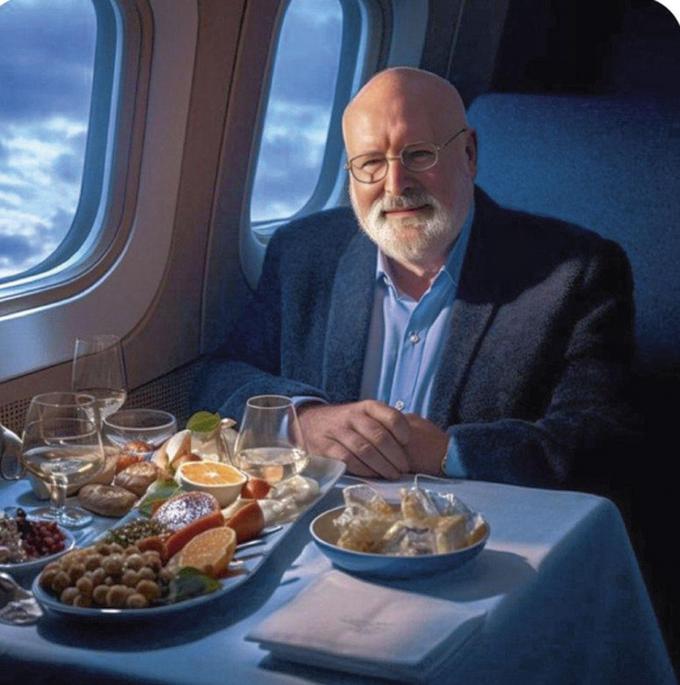

Privévliegtuig

Enkele dagen voor de recente Nederlandse verkiezingen, die eindigden in een klinkende overwinning voor de Partij voor de Vrijheid (PVV) van Geert Wilders, ging een foto van Frans Timmermans viraal op sociale media. De lijsttrekker van de gezamenlijke lijst GroenLinks-PvdA was erop te zien in een privévliegtuig, tevreden glimlachend bij een copieuze maaltijd en verschillende glazen wijn. ‘Frans Timmermans wil dat u minder gaat vliegen, maar dat geldt niet voor hemzelf’, was de boodschap die er meestal bij vermeld stond.

Alleen: het was helemaal geen foto van Frans Timmermans. Het beeld was nep, gemaakt met een beeldgenerator op basis van artificiële intelligentie. Sommige mensen die het prentje deelden, hadden dat door en beschouwden het als een ‘passende illustratie’. Maar anderen dachten dat het een échte foto was. Dan rijst de vraag: kan iemand die dat gelooft nog een geïnformeerde keuze maken in het stemhokje?

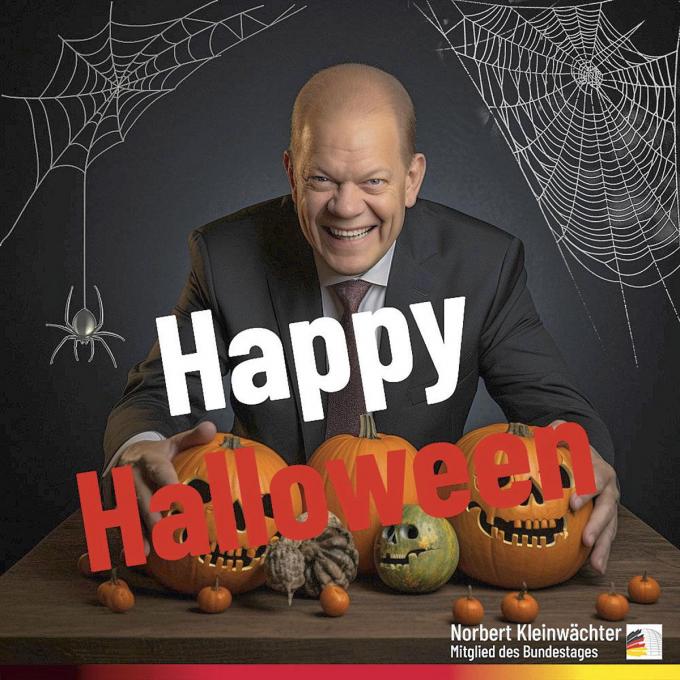

Het fake beeld van Timmermans is maar een van de voorvallen waarbij in 2023 gebruik is gemaakt van beeldgeneratie op basis van AI voor politieke campagnes. Ron DeSantis, de gouverneur van de staat Amerikaanse Florida en uitdager van Donald Trump in de Republikeinse voorverkiezingen, gebruikte in een van zijn spotjes beelden van Trump die innig knuffelde met Anthony Fauci, de bij Republikeinen onpopulaire immunoloog die de Amerikaanse overheid adviseerde tijdens de coronapandemie. In Duitsland verspreidde Norbert Kleinwächter, parlementslid van de radicaal-rechtse partij Alternative für Deutschland (AfD), geregeld AI-beelden op Instagram: een straat vol vechtende Arabische mannen, bijvoorbeeld, of weinig flatterende AI-beelden van politieke tegenstanders, zoals een griezelig grijnzende kanselier Olaf Scholz tijdens Halloween.

Kan iemand die nepbeelden gelooft nog een geïnformeerde keuze maken in het stemhokje?

In de VS liet de Republikeinse Partij met behulp van een beeldgenerator zelfs een integrale campagnevideo maken, vol apocalyptische foto’s die voorafspiegelden wat er volgens hen zou gebeuren tijdens een tweede termijn voor de Democratische president Joe Biden: China valt Taiwan binnen, een bankencrisis breekt uit en migranten overspoelen de zuidelijke grens met Mexico. In piepkleine letters links bovenaan was te lezen: ‘Integraal gemaakt met AI-beelden.’ Vorige week nog lanceerde het Republican National Congressional Committee een nieuwe campagnevideo met AI-beelden. De iconische nationale parken van de VS stonden daarin propvol tentjes van ‘illegale immigranten’.

Ook politieke partijen in ons land gebruiken al generatieve AI in hun communicatie, en niet alleen voor positief bedoelde boodschappen. Nadat PVDA-voorzitter Raoul Hedebouw enkele weken geleden in een debatprogramma een controversiële uitspraak had gedaan over hoofddoeken voor jonge moslima’s, maakte het Vlaams Belang een visual om zijn standpunt aan de kaak te stellen: Hedebouw stond erop afgebeeld met zijn beide armen om twee meisjes met hoofddoek, met op de achtergrond het duistere interieur van een moskee. Die achtergrond was duidelijk met AI-technologie vervaardigd. Een woordvoerder van Vlaams Belang bevestigde: ‘Dat zit in Photoshop tegenwoordig.’

Fake stemmen

Behalve voor het vervaardigen van beelden kan AI-technologie ook gebruikt worden om stemmen te ‘klonen’. Een systeem dat getraind is op het stemgeluid van een bepaalde politicus kan eender welke boodschap brengen met die gekloonde stem, die niet of nauwelijks te onderscheiden is van de echte.

Ook dat fenomeen dook al op in de context van een Europese stembusgang, met name kort voor de parlementsverkiezingen in Slowakije, die gewonnen werden door de pro-Russische populist Robert Fico. Op sociale media circuleerde een geluidsbestand van een gesprek tussen Michal Simecka, het boegbeeld van een progressieve, pro-Europese partij, en journaliste Monika Todova.

Daarin schepte Simecka op over het vervalsen van de verkiezingen en het kopen van stemmen bij de Roma-bevolking. In een ander audiobericht viel te horen hoe Simecka zogenaamd van plan was om de bierprijzen te verdubbelen als hij na de verkiezingen aan de macht zou komen. In beide gevallen ging het om met AI gegenereerde nepstemmen. Heeft dat een impact gehad op de verkiezingsuitslag? We hebben er het raden naar.

Regelgeving

De ontwikkeling en het gebruik van AI-technologie gaat sneller dan eventuele regelgeving erover kan volgen. Het Europees Parlement debatteert al een tijd over een AI-wet die sinds de eerste versie in 2021 al verschillende keren ingehaald is door de werkelijkheid.

De vaakst opgeworpen manieren om het gebruik van AI te reguleren zijn ofwel een (gedeeltelijk) verbod, ofwel een verplichting tot transparantie: een vermelding dat er AI-technologie gebruikt is. Niet alleen overheden leggen zulke regels op. Ook internetgiganten als Google en Meta (het moederbedrijf van onder meer Facebook en Instagram) hebben aangekondigd dat ze politieke adverteerders zullen verplichten om het kenbaar te maken als advertenties gebruikmaken van AI.

Manipulatie

Maar zelfs als overheden of socialmediaplatformen duidelijke regels opstellen én afdwingen voor de toepassing van generatieve AI in officiële verkiezingscampagnes, bestrijkt dat niet het hele veld waarop artificiële intelligentie een rol kan spelen. Niet-officiële trolaccounts kunnen nog altijd naar believen AI-beelden verspreiden en op een organische manier viraal gaan. Hyperpartijdige websites die zich voordoen als nieuwswebsites gebruiken steeds vaker of zelfs exclusief AI-gegenereerde beelden als illustraties. Die zijn niet alleen goedkoper dan aangekochte foto’s, ze kunnen het leespubliek subtiel manipuleren.

Daarnaast kunnen democratische processen gemanipuleerd worden via buitenlandse inmenging. Een recent onderzoek van het Institute for Strategic Dialogue toonde aan dat AI al gebruikt wordt voor desinformatiecampagnes die conversaties op sociale media verstoren. De onderzoekers ontdekten een cluster van tientallen ogenschijnlijk Amerikaanse Twitterprofielen die – in het Engels en tijdens de Russische kantooruren – negatieve tweets verstuurden over de Russische oppositiepoliticus Aleksej Navalny. Bij het schrijven van die berichten werd ChatGPT gebruikt. Dat werd duidelijk toen sommige profielen het typische bericht tweetten dat ChatGPT als antwoord geeft op vragen die het systeem van de programmeurs niet kan of mag beantwoorden.

In Slowakije maakte een met AI gemaakt audiobericht mensen wijs dat een politicus de bierprijzen wilde verdubbelen.

Gerichte campagnes tegen een regering of politieke partij zijn door tekstgeneratoren op basis van AI veel makkelijker geworden. Vroeger waren er grofweg twee opties: ofwel eenvoudig te detecteren spamnetwerken die telkens hetzelfde bericht verspreidden, ofwel ‘trollenfabrieken’ waar elk personeelslid zelf berichten tikte. Met AI is het nu mogelijk om een oneindig aantal ‘unieke’ reacties, gegenereerd door een chatbot, op de socialemediapagina’s van je doelwit los te laten. De kwaliteit van de inhoud en de vertaling gaat er ook op vooruit. Vroeger kon je buitenlandse trollen vaak herkennen aan krom Engels of vreemde uitdrukkingen.

Valse beschuldigingen

Maar de grootste politieke impact van ‘generatieve AI’ – de technologie die zelf teksten, beelden en geluiden kan maken – is niet zozeer dat mensen af en toe in een deepfake trappen. Stilaan rijpt bij de bevolking zelfs het besef dat met AI-gegenereerde media bestaan en kunnen misleiden. Het grootste gevaar is dat generatieve AI het vertrouwen in onze capaciteit om echt en nep van elkaar te onderscheiden volledig kan doen ineenstorten.

Het loutere bestaan van AI-technologie is al voldoende om twijfel te zaaien over échte beelden. Een politicus die in de toekomst geregistreerd wordt terwijl hij iets onwelvoeglijks doet, kan altijd insinueren dat het om een AI-fabricatie gaat. In de huidige oorlog in Gaza zagen we al dat AI-beelden gebruikt worden als propagandamiddel – fictieve, gegenereerde beelden van gewonde Palestijnse kinderen, bijvoorbeeld. Dat leidt er dan weer toe dat de waarachtigheid van echte beelden van Palestijnse slachtoffers wordt betwist.

Dit najaar werd al aangetoond hoe moeilijk AI het factcheckers zal maken. In oktober 2023 plaatste een anoniem Twitterprofiel een geluidsbestand van 24 seconden op Twitter waarin – zo werd beweerd – te horen was hoe Keir Starmer, leider van de Britse oppositiepartij Labour, op een conferentie een medewerker uitschold. Labour deed de opname af als een vervalsing, en dat deed ook de conservatieve veiligheidsminister Tom Tugendhat. ‘Deepfakes bedreigen onze vrijheid’, reageerde hij op het voorval.

Maar factcheckers van FullFact besloten dat het niet met zekerheid te achterhalen viel of het fragment een echte opname was, dan wel een stemimitator of AI-vervalsing. Het was weliswaar verdacht dat de audiofile eerst was opgedoken bij een anoniem profiel dat al eerder negatieve en foute berichten over Starmer had verspreid, maar ontegensprekelijk aantonen dat het geluidsfragment nep was, bleek onmogelijk. De huidige analysetools waarvan wordt beweerd dat ze AI-producten kunnen herkennen, hebben in het verleden al vaak vals-positieve resultaten opgeleverd en zijn zeker nog niet geperfectioneerd. Dat opent, zeker op korte termijn, een venster om vlak voor een stembusgang twijfel te zaaien onder de bevolking.

Gerichte beïnvloeding

Maar misschien wel het allergrootste gevaar schuilt in de mogelijkheden van AI op het vlak van microtargeting. Uit onderzoek is al gebleken dat e-mails waarin Amerikaanse politici om donaties vragen, effectiever zijn wanneer ze worden geschreven door ChatGPT. Een politieke partij kan AI-technologie gebruiken om kiezers individueel te beïnvloeden. Verschillende partijen communiceren nu al met kiezers via WhatsApp.

Wat als elk individu op verkiezingsdag een hoogstpersoonlijk berichtje krijgt, toegespitst op zijn hoogstpersoonlijke bekommernissen, geschreven door een AI-chatbot die overtuigender klinkt dan eender welke reclameman? Het is wat Sam Altman, de topman van ChatGPT-maker OpenAI, zijn grootste vrees noemde: ‘Een-op-een interactieve desinformatie’ met de hulp van artificiële intelligentie.

Niemand zal bij het zien van het AI-filmpje met Dehaene gedacht hebben dat de CD&V erin geslaagd was om de oud-premier uit de doden te doen opstaan. Maar het vermogen van AI om mensen subtiel te beïnvloeden en gesofisticeerde desinformatiecampagnes te creëren moet politieke partijen er wel toe aansporen om twee keer na te denken voor ze het als wapen gebruiken. ‘The beast is back?’ Het politieke beest Jean-Luc Dehaene zal niet meer terugkeren, maar het AI-beest krijgt de politiek waarschijnlijk nooit meer geketend.