Van Facebook tot TikTok: fake news is minder bedreigend dan u denkt

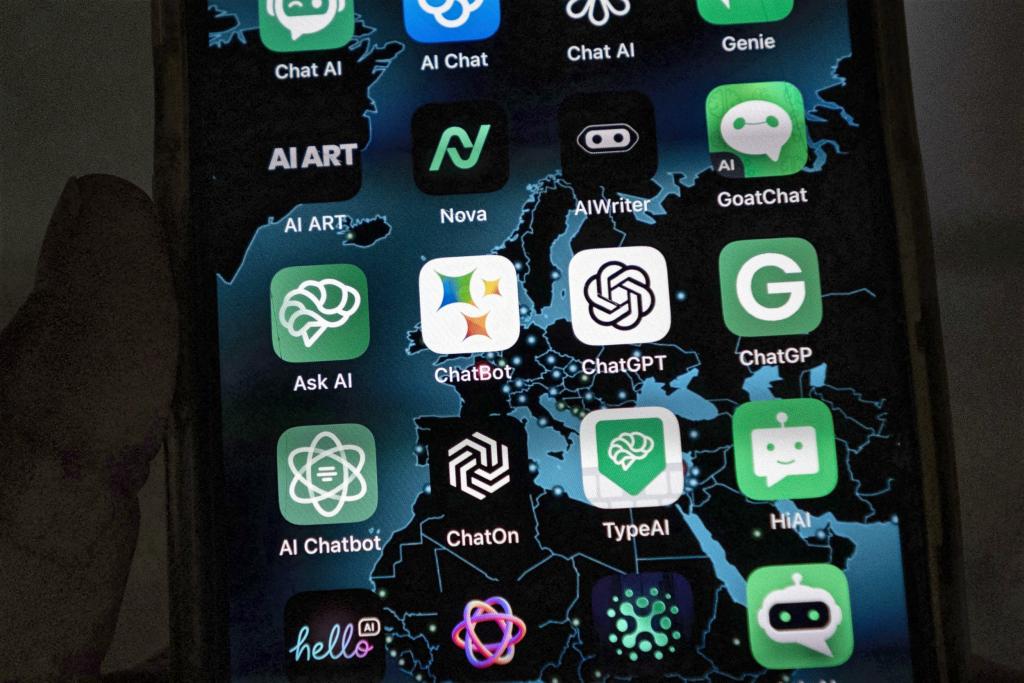

Wetenschappers buigen zich over de verspreiding van fakenewsberichten. Hun impact lijkt vooralsnog bescheiden te zijn. Maar de opmars van artificiële intelligentie kan dat veranderen, in slechte én in goede zin.

‘Het is nooit gemakkelijker geweest om valse of misleidende informatie te verspreiden dan vandaag’, stellen wetenschappers die in het vakblad AIP Advances nieuwe inzichten publiceren over hoe fakenewsberichten zich voortplanten. Ze wijten het aan de ‘onpersoonlijke aard’ van het internet, die het gemakkelijker maakt om waarheid te manipuleren en moeilijker om feiten en fictie van elkaar te onderscheiden.

Klassieke simulatiemodellen van de verspreidingspatronen van valse nieuwsberichten maken een analogie met de manier waarop besmettelijke virussen of bacteriën een epidemie uitlokken. Maar dat verklaringsmodel schiet volgens de nieuwe inzichten tekort, omdat het enkel een passieve verspreiding impliceert: je raakt besmet of niet. Het nieuwe model heeft meer weg van een nucleaire kettingreactie. Die gaat niet alleen sneller dan een epidemie, maar omvat ook ‘actieve factoren’, zoals geladen deeltjes, die elkaar aanstoten tot actie. De verspreiding van fake news is geen strikt passief gegeven, ze wordt beïnvloed door echte gebeurtenissen en door de mindset van mensen.

De studie leverde concrete inzichten op. Zo hangt de snelheid van verspreiding van fake news af van het aandeel ‘rationele internetgebruikers’ in een systeem, dat dan weer gerelateerd is aan het niveau van educatie: hoe hoger mensen opgeleid zijn, hoe minder snel fake news verspreid raakt. De verspreiding van valse berichten blijkt aanvankelijk meestal ook traag te gebeuren. Het impliceert dat er mogelijkheden zouden zijn om ze te counteren, gesteld dat iemand dat zou willen en er op tijd bij is.

Mensen houden niet van complexiteit en reageren dikwijls emotioneel op berichten die ze als storend ervaren.

Waarheidlievende mensen

Fake news is van alle tijden, blijkt uit een analyse van filosoof Antoon Vandevelde (KU Leuven) in het wetenschappelijke blad Karakter. ‘We weten dat er gepatenteerde leugenaars zijn, maar toch gaan we er meestal van uit dat de mensen met wie we praten oprecht zijn’, schrijft hij. ‘Tegelijk weten we dat zelfs waarheidlievende mensen zich graag wat mooier voordoen dan ze zijn, dat ze vaak de neiging om op te scheppen niet kunnen weerstaan, dat ze hun wensen voor werkelijkheid nemen, en dat ze zich niet alleen door de zucht naar waarheid laten leiden maar ook door hun belangen.’

Bovendien oriënteren velen van ons zich in de wereld ‘met behulp van verhalen uit religieuze en culturele tradities die niet letterlijk waar zijn’. Vandevelde concludeert dat we met die complexiteit hebben leren leven, maar ook dat ‘de ingebakken ambiguïteit in onze verhouding met de waarheid in de hedendaagse informatiemaatschappij nieuwe en onvermoede problemen veroorzaakt’. Hij gebruikt dat inzicht voor een intrigerende analyse van de noodzaak van het al dan niet beperken (‘reguleren’) van de vrije meningsuiting. Want ‘de vrije markt van de ideeën werkt helemaal niet goed in het elimineren van onwaarheden’.

Mensen houden niet van complexiteit en reageren dikwijls emotioneel op storende berichten, waarbij ze zich graag vastklampen aan wat ze al weten. Het is een probleem waarmee, bijvoorbeeld, klimaatwetenschappers te kampen krijgen. Veel mensen beseffen wel dat er een probleem dreigt, maar het is niet acuut genoeg en het vergt te veel persoonlijke inzet (in de vorm van gedragsveranderingen) om er iets aan te doen, waardoor ze blijven leven alsof er niets aan de hand is.

Democratie bedreigd

Toch woedt er in de wetenschappelijke wereld een verrassend hevig debat over de vraag in welke mate fake news daadwerkelijk een funeste invloed heeft op mensen. ‘Desinformatie blijft een bedreiging voor de democratie’, kopte het topvakblad Nature boven een artikel dat focust op de beïnvloedbaarheid van kiezers in verkiezingscampagnes – iets wat het laatste jaar sterk aan de orde was (en is), niet alleen bij ons maar ook in de rest van de wereld.

De analyse draaide vooral om een reflectie over de geloofwaardigheid van wetenschappers in een wereld die bulkt van de populistische bewegingen en te maken krijgt met een groeiende weerstand tegen ‘experts’, ook in politieke kringen. Er wordt twijfel gezaaid over feiten door constant te hameren op een zogezegd wazig onderscheid tussen ‘waar’ en ‘niet waar’ – vergelijkbaar met hoe sigarettenproducenten of oliemaatschappijen lang twijfel hebben gezaaid over de gevaren die verbonden zijn aan het gebruik van hun producten.

‘Bovendien,’ stellen de auteurs, ‘wordt de promotie van meningen die ingaan tegen een wetenschappelijke consensus dikwijls verzorgd door individuen die zichzelf presenteren als heroïsche rebellen.’ Veel mensen gaan erin mee, zeker als een mening aansluit bij hun politieke of ideologische overtuiging. Onderzoekers wijzen ook op het gevaar van charismatische online-influencers met veel volgers, die dikwijls veel geld verdienen met het promoten van soms ronduit gevaarlijke berichten, bijvoorbeeld over alternatieve gezondheidsclaims. ‘Als je iets trendy kunt maken, maak je het meteen ook waar’, klinkt het.

Coronavaccins

In een ander artikel in Nature, dat meer dan 2,5 jaar nodig had om gepubliceerd te raken, nuanceren wetenschappers dan weer de gevaren van onlinemisleiding – onder hen iemand van Microsoft Research. De studie identificeert ‘drie algemene misvattingen’: de blootstelling aan problematische berichten is hoog, de algoritmen van zoekmachines zijn er grotendeels verantwoordelijk voor, en sociale media zijn de voornaamste drijvende kracht achter de polarisatie in de samenleving. Ze weerlegt ze alle drie (waarmee ze niet wil zeggen dat er geen problemen zijn).

De blootstelling aan problematische berichten zou voor de meeste mensen bescheiden zijn. Ze is sterk geconcentreerd op een minderheid van mensen die er sowieso al extreme meningen opna houden – herinner u de verspreiding van desinformatie over coronavaccins. De meeste mensen die sociale media gebruiken, krijgen vooral gematigde berichten te zien.

Het zijn ook niet de algoritmen die de blootstelling aan probleemberichten in de hand werken, wel het gedrag van mensen met extreme visies zelf, in hun zoektocht naar informatie om hun overtuiging te versterken. Toen het toenmalige Twitter (nu X) tussen 8 en 12 januari 2021, in de naweeën van de bestorming van het Amerikaanse Capitool, 70.000 verspreiders van fake news blokkeerde, verliet een massa niet-geblokkeerden meteen zelf het kanaal.

Wetenschappers gaan ervan uit dat een app als ChatGPT meer doet dan na-apen wat hij geleerd heeft – hij speelt een rolletje.

Finaal stellen de auteurs dat zowel de polarisatie in de samenleving als het gebruik van sociale media de laatste decennia is toegenomen, maar dat het niet voor de hand ligt dat er een causaal effect is: sociale media zouden het gedrag van mensen minder sturen dan wordt aangenomen. Het verwarren van correlatie en causaliteit is een klassieke denkfout. Ze poneren zelfs dat politici en journalisten via klassieke media een grotere impact hebben op het verspreiden van fake news dan sociale media.

Na het oorlogje met de EU: ‘Fake news’ gaat breder dan het X van Elon Musk

Digitale propaganda

‘De waarheid over digitale propaganda’ was de kop boven een analyse in het magazine New Scientist, die ook al concludeerde dat het effect van onlinemanipulatie op de democratie bescheiden is. Ze houdt wel een slag om de arm door te stellen dat sociale media nog geen twintig jaar dominant zijn in ons systeem, waardoor sommige effecten misschien nog niet tot uiting komen. Maar voorlopig blijven het ‘monsters in de schaduw’. De massa berichten die, bijvoorbeeld, politici via Facebook, TikTok en WhatsApp op potentiële kiezers loslaten, hebben meestal niet meer dan een bescheiden effect.

Dat komt onder meer omdat het, ondanks het feit dat mensen dikwijls veel informatie over hun leven en ideeën op het internet achterlaten, toch relatief moeilijk blijkt om er een gedetailleerd persoonlijk profiel uit te distilleren, waarop berichtenverspreiders zich zouden kunnen enten. Een recente studie van 113 nationale verkiezingen in 95 landen, gepubliceerd in Journal of Quantitative Description: Digital Media, concludeerde dat in de grote meerderheid van de onlinecampagnes slechts één kenmerk (meestal leeftijd of geslacht) gebruikt werd om kiezers ‘persoonlijk’ aan te spreken. Microtargeting, zoals het concept van het individualiseren van boodschappen in het jargon heet, is vooralsnog heel bescheiden.

Een studie in Science Advances besloot dat het effect van ‘gepersonaliseerde’ politieke boodschappen op kiezers zo klein is dat het amper meetbaar is. Slechts zeven personen op de duizend zouden hun mening veranderen na het zien van politieke advertenties op sociale media. De voornaamste conclusie: online effecten zijn kleiner dan de hype rond sociale media en misinformatie suggereert. Deur-aan-deurbezoeken en telefonische contacten met potentiële kiezers hebben nog altijd een groter effect. En ook: mensen zijn moeilijker te misleiden dan velen aannemen.

Gezonde argwaan

Een punt is wel dat mensen nieuwe technologieën automatisch als een reden voor bezorgdheid zien. Mensen zijn beter in het interpreteren van informatie uit kanalen die ze kennen dan in het omgaan met wat uit nieuwe kanalen komt. Zelfs wetenschappers zitten met de handen in het haar als het erop aankomt de effecten van de nieuwste technologieën, zoals diverse vormen van artificiële intelligentie (AI), te interpreteren.

Een Amerikaans academicus die twintig jaar als software-ingenieur voor Google werkte, stelt in Nature dat heel goed bekend is hoe de algoritmen achter zoekmachines werken, maar dat er totaal geen zicht is op wat een AI-tool, zoals de taalapp ChatGPT, ‘denkt of doet’. De ‘interne werking’ van de app is een mysterie, maar het is wel duidelijk dat hij meer doet dan na-apen wat hij geleerd heeft. Of hij zelf kan plannen is onduidelijk. De meeste wetenschappers houden het erop dat hij ‘een rolletje speelt’. Ze zeggen ook dat je over chatbots zoals ChatGPT ‘dezelfde gezonde argwaan moet koesteren die je hebt als je praat met iemand die je niet goed kent’.

En hoewel veel mensen ondertussen AI-tools gebruiken, wordt het spookbeeld van misleidende en ronduit valse informatie die ze zouden verschaffen opgepookt – niet helemaal zonder reden trouwens, als je ziet wat de desastreuze gevolgen van onder meer deepfakevideo’s kunnen zijn. Het Wereld Economisch Forum classificeerde ‘door AI versterkte desinformatie’ als een van de grootste risico’s waar de wereld momenteel mee geconfronteerd wordt.

Fake news in Europa: ‘80 procent van de desinformatie die hier circuleert komt uit Rusland’

Instrument voor waarheid

Toch is het ook hier niet allemaal kommer en kwel, zeker als je ziet hoe AI onder meer in de geneeskunde tot nieuwe inzichten leidt. In Science verscheen recent zelfs een verrassende studie die aantoont dat AI als ‘instrument voor waarheid’ kan fungeren. Mensen die geloven in complottheorieën zijn meer geneigd hun mening te herzien na confrontatie met AI-berichten dan na contacten met andere mensen. Het werkt voor uiteenlopende complotten, van de dood van prinses Diana via de aanwezigheid van aliens tot de verspreiding van het coronavirus.

Opvallend was dat echte complotten er immuun voor zijn, zoals het Echelon-verhaal waarin landen als de Verenigde Staten en Groot-Brittannië samenspanden om satellietcommunicatie af te luisteren, of het Tonkin-incident uit 1964 dat de VS dichter bij een oorlog tegen Noord-Vietnam bracht.

‘De techniek van AI-dialoog is zo krachtig omdat hij automatisch specifieke en grondige tegenargumenten tegen goed onderbouwde overtuigingen van complotdenkers blijft verschaffen’, concludeert de studie. En ook: een AI-tool reageert niet emotioneel, wat zijn geloofwaardigheid versterkt. Het is een ontnuchterende gedachte dat een machine in de strijd tegen complotdenken efficiënter kan zijn dan een mens.

Fout opgemerkt of meer nieuws? Meld het hier