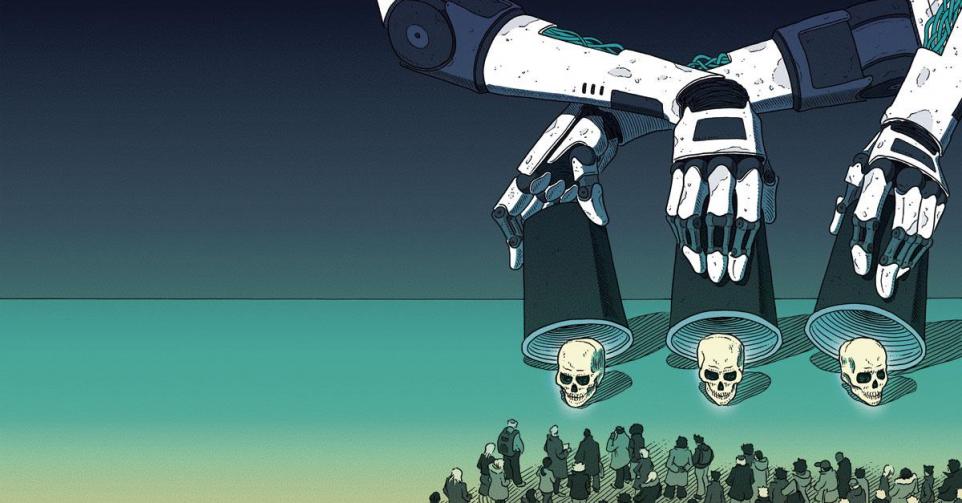

Artificiële intelligentie: ‘In het slechtste geval kan het tot onze ondergang leiden’

Artificiële intelligentie kan ons helpen om de complexe problemen van onze tijd op te lossen, zegt techniekfilosoof Lode Lauwaert. ‘Maar er moet meer aandacht zijn voor de catastrofes die AI kan veroorzaken.’

‘Dit is een uniek moment in de geschiedenis’, zegt techniekfilosoof Lode Lauwaert terwijl we onder de najaarszon koffiedrinken op een bank in zijn tuin. De banaliteit van het tafereel staat in schril contrast met wat hij vertelt. ‘Voor het eerst in de 250.000 jaar dat de mens bestaat, creëren we iets wat binnen drie decennia intelligenter kan worden dan wij en dat in het slechtste geval tot onze ondergang kan leiden.’

Dat ‘iets’ is artificiële intelligentie (AI).

Grote catastrofes zijn er altijd geweest. 66 miljoen jaar geleden betekende een meteorietinslag het einde van de dinosauriërs. ‘Maar dat type ramp is, net als vulkaanuitbarstingen, natuurlijk van aard’, zegt Lauwaert. ‘Pas met de uitvinding van de atoombom creëerde de mens zelf iets wat zijn ondergang kon betekenen.’ Toch liggen de kaarten met AI nog anders. ‘Als die systemen straks een eigen leven gaan leiden, kan voorlopig niemand garanderen dat we de stekker er tijdig uit kunnen trekken.’

Waarom zijn we niet in paniek?

Lode Lauwaert: Omdat de mens notoir slecht is in het erkennen van grootschalige rampen. Ergens valt dat te begrijpen. Het is bijzonder moeilijk om ons iets voor te stellen bij zo’n catastrofe. We weten hoe een vulkaanuitbarsting eruitziet en sinds kort weten we ook wat er gebeurt tijdens een pandemie, maar een AI-ramp, daar hebben we geen beeld van. Tenzij uit films, en dat verklaart meteen waarom we zulke scenario’s beschouwen als sciencefiction.

Het is wel bijzonder dat de mensen die de technologie ontwikkelen ook de mensen zijn die ervoor waarschuwen.

Lauwaert: De kritiek is dat mensen die wijzen op de problemen met hypergeavanceerde AI daar belang bij hebben. ‘Kijk eens waartoe wij in staat zijn’, zou de onderliggende boodschap zijn, terwijl dat de aandacht van bestaande AI-problemen afleidt. Ik kan me erg druk maken over dat soort commentaar. Het is mogelijk dat ze er belang bij hebben, maar dat betekent nog niet dat wat ze zeggen fout is. Bovendien zijn er ook tal van wetenschappers die wijzen op mogelijke rampen. Kosmoloog Stephen Hawking deed het al in 2014 in een interview met de BBC.

U was lang van mening dat technologie die de mensheid wegveegt, thuishoort in sciencefiction. Waarom bent u van gedachte veranderd?

Lauwaert: Technologie zorgt voor vooruitgang, welvaart en welzijn, maar tegelijk zijn er onwenselijke neveneffecten, zoals discriminatie door algoritmen. De lancering van ChatGPT en de razendsnelle evolutie van AI heeft ons anders naar die technologie doen kijken. Dat AI plots nieuwe dingen kan die zelfs de experts niet hadden voorzien, heeft daartoe bijgedragen. Sindsdien denken mensen na over de catastrofes die AI zou kunnen veroorzaken. Zo ging de Britse AI-pionier Geoffrey Hinton weg bij Google om vrij te kunnen waarschuwen voor de gevaren van de technologie die hij mee ontwikkelde. Sommige mensen, vaak uit de humane wetenschappen, focussen alleen op de risico’s die AI vandaag al in zich draagt, zoals bias en discriminatie. Maar echt problematisch is dat ze de grotere risico’s lijken te negeren. Het klopt dat de kàns op die andere risico’s groter is, maar dat betekent niet dat we de grotere risico’s naast ons neer mogen leggen. Dat is ook wat iedere risico-expert beweert, en wat je in elk handboek over risicomanagement leest.

Voorlopig kan niemand garanderen dat we de stekker er tijdig uit kunnen trekken.

Wat houdt zo’n catastrofe precies in?

Lauwaert: Stel je voor dat we een AI-model creëren dat zodanig intelligent is dat het op eigen houtje nieuwe, nóg intelligentere systemen begint te genereren. Het gevolg is dan een razendsnelle ontwikkeling van almaar intelligentere systemen die de menselijke denkkracht volledig overstijgen. Dat noemen ze, naar het idee van de Britse wiskundige Irving John Good uit 1965, een intelligentie- explosie. Omdat die systemen uitblinken in het bereiken van hun doelen zullen ze ook intelligent genoeg zijn om te voorkomen dat de mens daar nog in tussenbeide komt. Dat betekent dat we de controle verliezen.

Is zoiets mogelijk met de AI die we vandaag gebruiken?

Lauwaert: Nee, de AI die we vandaag kennen, is narrow AI: ze werkt slechts op één taak. Voordat een intelligentie-explosie zich kan voordoen, moet AGI of artificial general intelligence ontwikkeld worden. Dat is een systeem dat alles wat mensen kunnen ook kan, maar dan veel beter: teksten schrijven, wetenschappelijk onderzoek verrichten, banken beheren, pandemieën managen. Er is een grote kans dat AGI vroeg of laat een feit is. Wereldwijd concentreren tientallen bedrijven zich op de ontwikkeling ervan. De belofte is dan ook niet min: zo’n systeem zou de grote problemen van onze tijd kunnen oplossen. De financiële drijfveer is bijgevolg bijzonder groot. De meeste AI-wetenschappers zijn het erover eens dat er binnen dit en honderd jaar AGI zal zijn. Een kleinere groep verwacht het tegen 2060, en in het voorjaar liet Demis Hassabis, de ceo van Google DeepMind, optekenen dat hij AGI al binnen een tiental jaar mogelijk acht. Omdat technologie zich almaar sneller ontwikkelt, schatten wetenschappers die termijn steeds korter in.

Is het per definitie een probleem dat een machine intelligenter is dan de mens?

Lauwaert: Als zo’n hyperintelligent systeem alleen maar goede doelstellingen heeft, zoals pakweg het oplossen van de klimaatcrisis, dan klinkt dat in eerste instantie niet slecht. Alleen hebben we vaak geen idee op welke manier die doelen gerealiseerd worden. AI-systemen functioneren als een black box (een complex proces waarvan het verloop onduidelijk is, nvdr), en daardoor kunnen onbedoelde neveneffecten rampzalige gevolgen hebben. De Zweedse filosoof Nick Bostrom illustreerde dat aan de hand van een gedachte-experiment. Stel dat een AI-systeem het eenvoudige doel heeft om zo veel mogelijk paperclips te maken, dan zal het daarvoor op zoek gaan naar grondstoffen. Alles wat ook maar een beetje metaal bevat, moet eraan geloven. De wereld wordt een grote paperclipfabriek en iedereen die dat wil verhinderen, wordt van kant gemaakt. De wereld is geruïneerd, maar het systeem heeft wel zijn doel bereikt. Minder fictief: stel dat we binnen dertig jaar superintelligente AI hebben om de verzuring van de oceanen aan te pakken. Het systeem berekent dat het verdwijnen van grote stukken aardoppervlak de oplossing is. Als dat doel gerealiseerd wordt, is het neveneffect daarvan een grote ramp.

Als AI ooit mensen uit de weg ruimt, dan zal ze dat doen omdat ze een doel heeft dat ze zo snel en zo efficiënt mogelijk wil bereiken.

Nu lijkt het wel alsof AI een overlevingsinstinct heeft. Geeft u machines niet te veel krediet?

Lauwaert: Als AI-systemen mensen uit de weg ruimen, dan zullen ze dat niet doen omdat ze slechte bedoelingen hebben, maar omdat ze een doel hebben dat ze zo snel en zo efficiënt mogelijk willen bereiken. Het gevaar schuilt dus niet in een soort bewustzijn maar in de intelligentie, in de rekenkracht. Hoe slimmer een AI-systeem is, hoe groter de kans op onveiligheid.

Moeten we dan langer stilstaan bij hoe afhankelijk we onszelf maken van AI?

Lauwaert: Zeker, en dat sluit meteen aan bij het tweede scenario waarin AI volgens mij tot catastrofes kan leiden: doelbewust controle afstaan aan machines omdat ze nu eenmaal sneller en efficiënter werken dan wij. Dat doen we al lang, maar dat betekent niet dat machines onfeilbaar zijn. In september 1983, in volle Koude Oorlog, waakte luitenant-kolonel Stanislav Petrov in de Sovjet-Unie over het alarmsysteem dat nucleaire raketaanvallen vanuit de Verenigde Staten traceerde. Op een bepaald moment ging het alarm af, maar Petrov vertrouwde het niet. Normaal moest hij de melding zo snel mogelijk doorgeven aan de leiding van de luchtafweer zodat van hogerhand beslist kon worden om een nucleaire tegenaanval te beginnen. Maar Petrov twijfelde en gaf een systeemstoring door. Uiteindelijk bleek het daadwerkelijk om een vals alarm te gaan. Het systeem had een reflectie van de opkomende zon op de wolken fout geïnterpreteerd als een raket. Mocht Petrov zijn buikgevoel niet gevolgd hebben, dan zou dat geleid hebben tot een nucleaire ramp.

Zullen we de controle in de toekomst vaker afstaan aan machines?

Lauwaert: Terwijl dat soort vals positieven nog altijd voorkomen, hevelen defensie en bedrijven vaker taken over naar AI. Dat zal alleen maar toenemen. Zeker als je naar het grotere plaatje kijkt. AI is ingebed in een economische logica. Alleen de beste bedrijven overleven. Als de implementatie van autonome AI bedrijven competitieve voordelen geeft, dan is het waarschijnlijk dat men meer autonomie zal geven aan die systemen. Dat is niet zonder gevaar. Hoe meer we automatiseren, hoe groter het risico wordt dat we vroeg of laat met een grote ramp te maken krijgen. Ook wat dat betreft, is een blik op de geschiedenis leerrijk. Na een reeks vreselijke ongevallen kwam de Ford Pinto in de jaren 1970 onder vuur te liggen. De wagenproducent zou uit financiële overwegingen niet gekozen hebben voor veiligere wagens. In de race met Airbus crashten in 2018 en 2019 twee Boeings 737. Gevolg: 348 doden. Ook de zogenaamde AI-race draagt zulke risico’s in zich.

Wat als AI misbruikt wordt door mensen met slechte bedoelingen?

Lauwaert: Dat is het derde scenario dat ik voor ogen heb, en waar volgens mij veel te weinig aandacht voor is. Terroristen en populistische, totalitaire leiders kunnen AI gebruiken om cyberaanvallen te plegen of om bioterreur te zaaien. AI kan de zwakke punten detecteren in de digitale infrastructuur of nieuwe, dodelijke virussen creëren die zich supersnel verspreiden. Er kunnen ook chemische wapens mee gemaakt worden. In 2022 werd een AI-systeem gebruikt om toxische moleculen te maken. In zes uur tijd werden er maar liefst 40.000 van gemaakt. Ze kunnen worden gebruikt in chemische oorlogsvoering.

Wie garandeert dat autonome killer robots nooit in handen zullen komen van terroristen of totalitaire leiders?

U hebt nu drie scenario’s genoemd. Welk vreest u het meest?

Lauwaert: Ik ben bang voor het controleverlies, maar het misbruik van systemen door mensen met slechte bedoelingen vind ik nog enger. Veel van mijn vrienden fronsen de wenkbrauwen als ik daarover begin. Maar nog geen jaar geleden werd gevreesd voor nucleaire aanvallen door Rusland, en in 1995 vond er een gasaanval plaats in de metro van Tokio. Wie garandeert dat autonome killer robots, die trouwens al gebruikt werden in Libië en Israël, nooit in handen zullen komen van terroristen of totalitaire leiders?

En welk scenario is het meest waarschijnlijk?

Lauwaert: Een ongeluk. Dat zou niet uitzonderlijk zijn. Denk aan de twee rampen die zich voordeden in 1986: de kernramp in Tsjernobyl en de explosie van het Amerikaanse ruimteveer Challenger. Die gingen allebei niet gepaard met slechte bedoelingen of een competitieve logica. Toch zijn die rampen gebeurd. Net als toen kan een ongeluk met AI de vorm van een catastrofe aannemen. Zeker omdat onze kennis van AI vele malen kleiner is dan die van ruimtevaart of kerncentrales. Om nog maar te zwijgen over het verschil in veiligheidsvoorschriften.

Hoe groot is de kans dat AI uit de bocht gaat?

Lauwaert: Ongeveer de helft van de AI- wetenschappers die geloven dat AGI er binnen de honderd jaar zal zijn, schat de kans dat AGI de mensheid wegveegt op 5 procent. Wat mij betreft, is de kans nog kleiner. Stel dat astronomen zouden zeggen dat er 1 procent kans bestaat dat er binnen honderd jaar opnieuw een grote meteoriet zou inslaan, dan zou men er alles aan doen om dat te voorkomen. Maar AI-ontwikkelaars die waarschuwen voor de gevaren van hun technologie worden niet altijd even ernstig genomen. Dan klinkt het vaak dat het gaat om een bende witte, mannelijke miljardairs die alleen hun eigen belangen verdedigen. Om maar een idee te geven van de teneur van het debat.

Wat kunnen we doen om die risico’s te voorkomen?

Lauwaert: Politici moeten meer aandacht hebben voor de rampen die AI kan veroorzaken. Dit is geen sciencefiction meer. Het is onverantwoord dat die aandacht er nu amper is. Midden september zei voorzitter van de Europese Commissie Ursula von der Leyen in haar State of the Union dat het inperken van de existentiële risico’s van AI wereldwijd prioriteit moet zijn. Eerder waarschuwde secretaris-generaal van de Verenigde Naties António Guterres ook al voor de mogelijke risico’s van de technologie. Wat mij betreft, komt er een internationaal agentschap waar onafhankelijk onderzoek wordt verricht naar AI en de mogelijke gevolgen ervan. Een agentschap dat erover waakt dat AI-systemen ethisch verantwoord handelen en zich buigt over de vragen die tot op de dag van vandaag onbeantwoord blijven. Willen we AGI? En als AGI er komt, hoe voorkomen we dan de ongewenste neveneffecten ervan? Hoe voorkomen we misbruik van zulke systemen? En vooral: willen we als mens de controle uit handen geven? Dat zijn volgens mij, naast die over klimaat, biodiversiteit en migratie, dé vragen van de 21e eeuw.

Wegen de voordelen van AI op tegen alle risico’s die ermee gepaard gaan?

Lauwaert: Absoluut. Alleen als een systeem een aanwijsbaar existentieel risico in zich draagt, helt het systeem over naar de negatieve kant. Maar ik ben ervan overtuigd dat AI de complexe problemen van onze tijd kan helpen oplossen: klimaat, gezondheid en veiligheid.

Lode Lauwaert

1981: Geboren in Jette.

1999-2004: Studie psychologie aan de UGent.

2004-2008: Studie filosofie aan de KU Leuven.

2008-2013: Doctoreert in de filosofie aan de KU Leuven.

2021: Publiceert Wij, robots. Een filosofische blik op technologie en artificiële intelligentie en wint er verschillende prijzen mee.

2022-nu: Professor techniekfilosofie en Chair Ethics and AI aan de KU Leuven.